Module 04 公平与问责制

1. 概览

1.1 公正与公平

- 公正(justice)和 公平(fairness)往往可以互换使用

- 高风险决策 —— AI

- 保释

- 量刑

- 抓捕罪犯

- 工作申请

- 福利

- 分配成绩

- 审查或产生错误信息

- 诊断疾病

- 保险

宽泛的定义:“给予各方应得的结果” 。

相似案例采取相似对待;对任意差异 “视而不见”

1.2 公正/公平的类型

- 平等尊重(Equal respect)

- 所有人类都有尊严(康德 —— 永远终结,绝不仅仅意味着)

- 种族、宗教、阶级、性别、性别、性取向等基本相同

- 分配公正(Distributive justice)

- 资源、机会

- 需求、价值、合同等

- 例如 是否应该给每个人同样的职业机会或者收入,而不论他们的才华如何?我们应该帮助那些遭受厄运的人们吗?我们应该偏袒在道德上负责而不是自私的人吗?

- 积极/逆向歧视 (Positive/reverse discrimination):为弱势和历史上受压迫的群体提供更多的资源/机会

- 程序公正(Procedural justice)

- 分配利益或损害的公平程序或程序

- 例如:大学只有 10 个名额,但是有 15 名同等资格的候选人

- 随机、排队

- 社会心理学家:许多人更关心被机构公平对待而不是实际结果

- 纯粹的程序正义:没有任何需求或优点等问题。我还有一个棒棒糖和两个朋友 —— 应该给谁?

- 惩罚公正(Retributive justice)

- 因不当行为处以罚款

- 基于实际罪行和公平程序(审判)

- 补偿公正(Reparative justice)

- 补偿不公平待遇

1.3 问责制(Accountability)

- 承担责任(责任)

- 例如:坚持公平的程序和分配

- 承担责任(负责)

- 通过外部压力和机制

- 例如:法律、职业、业务守则、同事、选举

- 谁负责?例如:研究人员、工程师、组织(私人和公共)、部署人员、主管部门

- 正确和公平的机制是什么?

2. 公平

2.1 算法公平(Algorithmic Fairness)

- 机器学习算法可能具有不公正的嵌入偏见

- 例如:不公平地歧视某些群体(种族、性别等)

- 显式或者通过代理

- 减少不公平现象的技术解决方案

- 例如:改变输入

- 例如:改善数据集的处理

- 例如:更改错误的权重,–ves vs. + ves

- 数学度量,例如(Berk等人2018):

- 整体准确率相等(overall accuracy equality)

- 统计平等(statistical parity)

- 条件程序准确率相等(conditional procedure accuracy equality)

- 条件使用准确率相等(conditional use accuracy equality)

- 处理方式平等(treatment equality)

- 总公平(满足 1-5)

但是

- 伦理 vs. 技术问题:数学上的公平是否真的公平取决于所采用的公平标准。而且这个标准是有争议的。

- 因此导致了相关的伦理问题和争论

- 另外,由于以下原因,无法总是拥有完美公平的算法:

- 不可能定理(The Impossibility Theorem):“算法在数学上无法同时满足不同的流行的公平性度量”

- 例如:不公平地惩罚不经常触犯法律的某群体 X,以达到群体公平

- $\Longrightarrow$ 相同的待遇和不同的影响

- 固有权衡(The Inherent Tradeoff):在公平与性能之间权衡

- 例如:群体公平性的提高 $\Longrightarrow$ 保释累犯预测准确性的降低

- 减少假阳性(被告被错误地评估为高风险),但增加假阴性(忽略一些高风险的被告)(社会成本)

- 不可能定理(The Impossibility Theorem):“算法在数学上无法同时满足不同的流行的公平性度量”

2.2 ProPublica vs. Northpointe

-

COMPAS 累犯算法 • 重犯的风险评分:黑人和白人 • 确定保释金,参见。 可能有偏见的人 • 可能会减少虚荣率

- ProPublica

- AI 系统对黑人群体存在种族偏见

- 截然不同的影响:非犯罪黑人的风险评分高于非犯罪白人

- Northpointe

- 不可区别对待

- 算法中不使用任意差异(种族)

- 在每个 COMPAS 等级下,黑人和白人的再犯罪率均相等

2.3 道德框架与公平/公正

回顾我们之前提到过的四种常见的伦理框架:

- 功利主义:公平/公正 = 最大化净福利,即使必须使某些人的生活变得比其他人更糟。每个人的相似利益仍然被认为是平等的。

- 康德的义务论:认识到人的尊严并尊重自治。始终将自治代理视为目的,而绝不只是作为手段。

- 美德伦理:考虑一个公平公正的人会做什么。

- 关怀伦理:考虑特殊的关系以及由此产生的角色和责任。考虑对最弱势群体的影响。

所有这些框架都承认基本的人类平等,他们可能在算法上存在不同/相似的看法:

- 加强现有的不利条件,例如:增加针对某些群体的警力。

- 忽略过去影响算法预测从而导致对弱势群体产生偏见或消极歧视的压迫,以帮助弱势群体。

3. 问责制

Pak-Hang Wong 认为:

- 人工智能可能必然会创造赢家和输家–对不同人的危害和利益。

- 确定高风险 AI 的公平性并非仅仅是一项技术任务,而且还是一项伦理任务

- 但是:如何确保这一决定本身是公平的?

- 回忆:关于什么是公平这点目前并没有达成共识 + 完美的算法公平性是不可能实现的

- 程序公正

- 使 AI 设计者和所有者承担责任的最公平的机制是什么?

- 例如:AI伦理专家小组?

- 政治机制

3.1 合理性问责制(AFR)

- AFR 是从健康伦理学发展而来的

- “通过纳入和容纳他们的观点和声音,确保决策在道德和政治上对受到算法影响的人们是可接受的”

- AFR 假设不存在完全最终和 “正确” 的答案:答案是通过利益相关者进行公开、民主、善意的对话和推理得出的

- 关于什么是公平的 AI,不仅仅是由开发人员和研究人员确定

- AFR 包含四个条件

3.2 AFR 的四个条件

- 公开条件(Publicity condition:):关于算法公平性及其合理性的决定必须是可公开获取的、透明的,并且对于非技术人员来说也是可以理解的。

- 完全可接受的条件(Full Acceptability condition):对所有受影响的利益相关者,尤其是弱势群体,合理地解释所选的公平性参数,即给出公正的人可以接受的证据、原则、理由。

- 修订和上诉条件(Revision and appeals condition):具有持续的(不是一次性的)机制来质疑和解决争议以及修订政策。

- 监管条件(Regulative condition):对流程进行持续的公共监管,以确保满足上述条件(1)-(3)。

3.3 Northpointe 的 COMPAS 累犯预测 AI

- 公开条件:明确说明将使用哪些公平措施来预测再次犯罪。

- 完全可接受的条件:证明澄清为何所选择的参数和影响相关。受影响的人可以接受这些理由吗?例如,允许在历史上处于不利地位的黑人获得 “不同的影响”,同时又 “避免给予区别对待”?使用教育水平或成为犯罪的受害者 —— 对某些种族群体的负面影响更大吗?

- 修改和申诉条件:受影响者对这些理由提出异议的机制,例如,弱势群体,以及更广泛的社会代表。

- 监管条件:媒体将焦点放在 COMPAS 上,但没有更强有力的监管或执行。

Northpointe 不遵循 AFR 方法,也不受公共法规的追究。

最后一点:应该为此目的完全使用 AI 吗?

4. AI 与思维

4.1 思维哲学

- 思维的本质是什么?

- 与物质相同吗?

- 思维是大脑吗?

- 思考和理解是什么?

- 什么是意识?

- AI 可以有思想、思考、理解和意识吗?

4.2 图灵测试

图灵测试(Turing test),是英国计算机科学家艾伦·图灵(Alan Turing)于1950年提出的思想实验,目的在于测试机器能否表现出与人类等价或无法区分的智能。测试中的谈话管道仅限于使用文本,例如计算机键盘和屏幕,这样的结果不依赖于计算机把单词转换为音频的能力。

1950年,图灵发表了一篇划时代的论文,文中预言了创造出具有真正智能的机器的可能性。由于注意到 “智能” 这一概念难以确切定义,他提出了著名的图灵测试:如果一台机器能够与人类展开对话(通过电传设备)而不被辨别出其机器身份,那么称这台机器具有智能。这一简化使得图灵能够令人信服地说明“思考的机器”是可能的。论文中还回答了对这一假说的各种常见质疑。图灵测试是人工智能哲学方面首个严肃的提案。

测试内容:如果一个人(代号 C)使用测试对象皆理解的语言去询问两个他不能看见的对象任意一串问题。对象为:一个是正常思维的人(代号 B)、一个是机器(代号 A)。如果经过若干询问以后,C 不能得出实质的区别来分辨A与B的不同,则此机器 A 通过图灵测试。

John Searle 认为:

- 大脑和人的思维不是计算机

- 执行计算的 AI 永远不会有思维,即思考、理解、自觉人类所能做的和正在做的事

- 图灵认为:思维是一种计算,并且与思维过程中发生的事情无关,即我们可以用任何材料实例化思维:微芯片、真空管、啤酒罐

- 强人工智能:人工智能可以有头脑

- 弱人工智能:模拟特定领域内的人类思维,例如:国际象棋、医学诊断

4.3 中文房间

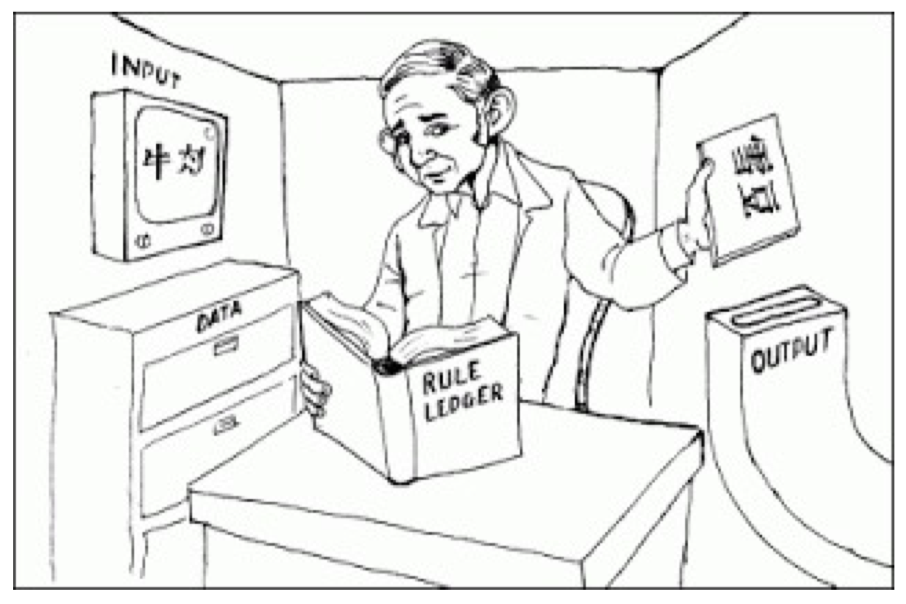

中文房间(Chinese room),是由美国哲学教授约翰·希尔勒(John Searle)提出的一个思想实验,借以反驳强人工智能的观点。根据强人工智能的观点,只要计算机拥有适当的程序,理论上就可以说计算机拥有它的认知状态并且可以像人一样进行理解活动。

实验过程:一个对中文一窍不通,只说英语的人关在一间只有一个开口的封闭房间中。房间里有一本用英文写成的手册,指示该如何处理收到的汉语讯息及如何以汉语相应地回复。房外的人不断向房间内递进用中文写成的问题。房内的人便按照手册的说明,查找合适的指示,将相应的中文字符组合成对问题的解答,并将答案递出房间。

约翰·希尔勒认为,尽管房里的人可以以假乱真,让房外的人以为他说中文,但事实上他压根儿不懂中文。在上述过程中,房外人的角色相当于程序员,房中人相当于计算机,而手册则相当于计算机程序:每当房外人给出一个输入,房内的人便依照手册给出一个答复(输出)。而正如房中人不可能通过手册理解中文一样,计算机也不可能通过程序来获得理解力。既然计算机没有理解能力,所谓 “计算机于是便有智能” 便更无从谈起了。

-

规则手册 = 计算机程序

-

规则手册的编写者 = 程序员

-

人 = 电脑

-

输入(问题)$\Longrightarrow$ 计算机 $\Longrightarrow$ 输出(答案)

-

通过了图灵测试

-

但是,这个人能够理解吗?

-

不能!他只是在操纵符号,而符号对这个人并没有任何意义 —— 就相关意义而言,他们根本没有思考

-

计算:语法 vs. 语义

例如,人/计算机不知道这些符号是关于什么的,即使头脑进行计算,也不足以进行思考、理解等。

-

对于构建更加复杂的系统(例如,并行处理、神经网络),或者提高图灵测试的性能使它看起来更像 “人类” 等(例如,使其显得机灵、有趣、知识渊博),并没有任何帮助。

-

AI 会 模拟(simulates)但不会 复制(duplicate) 思维。

相关回应:

针对非生物系统存在偏见(参见 “wet slimy stuff”)

- 希尔勒认为:必须与神经生物学系统(大脑)有关,这对于引起精神状态至关重要。

- 但是,希尔勒对非生物思维是持开放态度的,而且并不仅仅是计算方面的。

整个系统就是思维:人 + 书 + 符号篮子

- 希尔勒认为:人们记忆规则等。

机器人回复:

- 计算机与世界隔离,但机器人与世界存在因果关联:可以在物理空间和物体中感知和响应的 AI 可能与希尔勒的中文房间不同,例如:可以老练地下国际象棋。

重新审视图灵测试:

- 虽然中文房间中的人的理解似乎是违反直觉的,但是否认一个完全熟悉的未来 AI(例如,电影《她》)的理解似乎也是违反直觉的。

4.4 总结

那么,AI 可以具有思维、思考、感觉等吗?强人工智能可能做到这点吗?

AI 可以有伦理代理吗?对行为负责吗?大概不能,如果不能思考等。

思维哲学中的复杂问题 —— 理解:问题的本质和难度。

总的来说,我们在本节课中讨论了:

- 不同类型的公平/公正 —— 人们关于什么是人工智能的合理使用无法达成共识

- 不可能定理和固有权衡:使 AI 无法实现 “完美” 公平

- 程序公平结果的问责框架,例如:理性、透明度、民主的讨论

- 能够对 AI 本身问责吗?AI 能听懂吗?图灵测试 vs. 中文房间

5. 推荐阅读

- This Thing Called Fairness: Disciplinary Confusion Realizing a Value in Technology.

- Is the Brain’s Mind a Computer Program?

- Democratizing Algorithmic Fairness.

本作品采用知识共享署名-非商业性使用-相同方式共享 4.0 国际许可协议进行许可。 欢迎转载,并请注明来自:YEY 的博客 同时保持文章内容的完整和以上声明信息!