Module 06 可及性与平等

1. 可及性(Accessibility)

1.1 什么是可及性?

基本上,如果技术可以被残疾人和其他人一样有效地使用,那么它就是可及的。

—— Thatcher (2004)

可及性是指尽可能多的人可以访问交互式产品的程度。重点是残疾人。

—— Sharp (2011)

可及性是指系统无需修改即可被尽可能多的人使用的程度。其目标:平等获取和消除基于残疾、技术或环境限制的获取障碍。可用性和可及性都属于兼容设计方法 —— 共同关注通用设计作为良好设计的基础。

—— Alexander (2004)

1.2 通用性和 HCI

可用性(Usability)和 人机交互(Human-Computer Interaction, HCI)首先注意到这一点 —— 参见 技术工件和用户界面的设计

- 硬件产品

- 软件接口等。

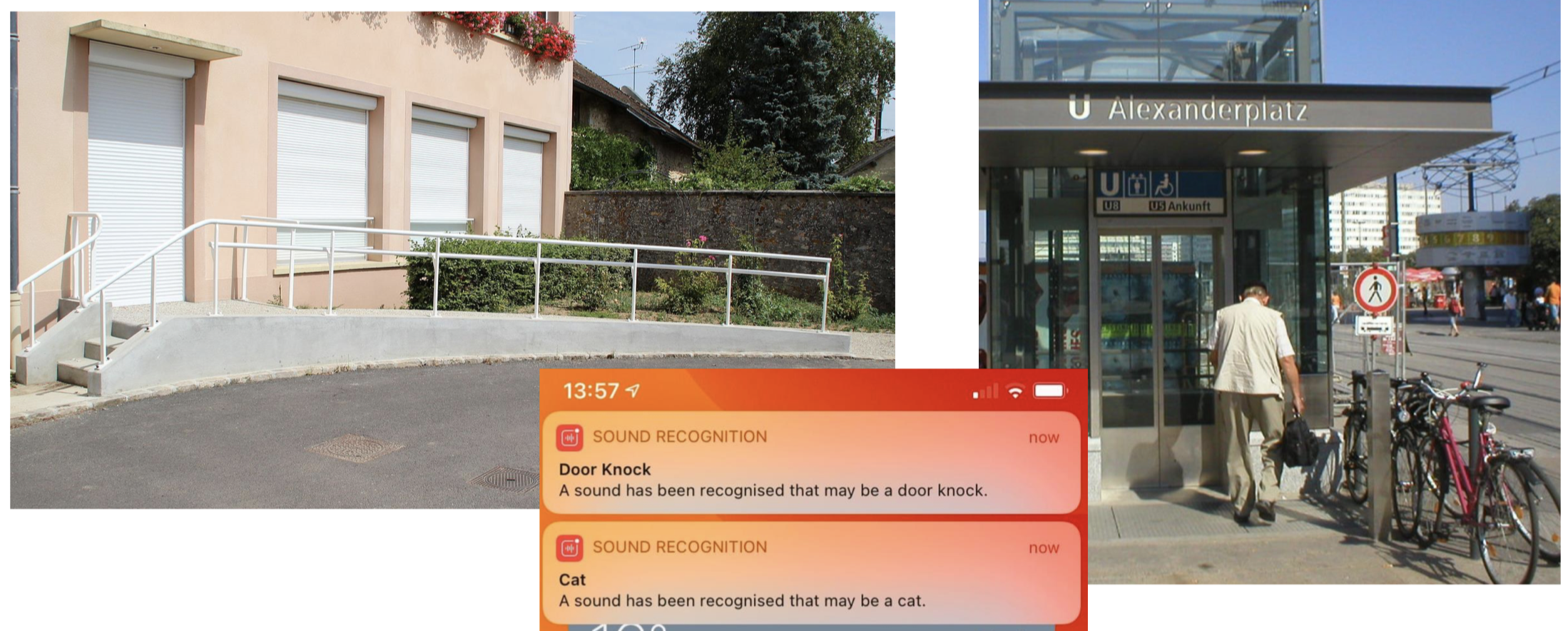

通用性(Universal Usability) = 一种 “面向所有人的设计” 方法,即让尽可能多的人可以使用产品。该术语起源于建筑行业(考虑楼梯 vs. 坡道/电梯/自动扶梯)。

1.3 例子

1.4 误解

可及性的概念范围不只限于 “为残障人士提供服务”,它还包括。

- 情境障碍(Situational impairments)

- 考虑:早餐高峰期忙碌的母亲

- 考虑:在人道主义危机中部署期间的国防人员

- 考虑:Covid-19 大流行期间的远程学习/工作

- 暂时性残疾/暂时性障碍(Temporary disability/temporary impairment)

- 考虑:一名学生在自行车事故后摔断了手臂

- 考虑:一位脊椎受伤的讲师

1.5 可及性和法律

具有里程碑意义的案例:Maguire 诉 SOCOG(悉尼奥运会组织委员会)

-

“Maguire 向人权和平等机会委员会 (HREOC) 提出投诉……(SOCOG)歧视他身为残障人士这点,这违反了《1992 年残障人士歧视法案》……”

-

要点:“未能提供可供 Maguire 访问的网站……”

-

“SOCOG 表示它没有非法歧视……为提供无障碍网站而重新培训员工和重新制定整个开发方法的成本和努力是一种不合理的困难……”

- 基本上:SOCOG 找借口(需要消耗太多时间等等);被专家证人驳斥!

- “专员发现 SOCOG 违反了 1992 年 DDA 第 24 条对 Maguire 的非法歧视”

- SOCOG 固执; “专员发现 SOCOG 仅部分遵守,因此,根据 DDA 第 103(1)(b)(iv) 条,专员判给 Maguire 20,000 美元。

1.6 反思

人机交互 (HCI),特别是 可用性研究(Usability studies)—— 这一 CS 的子领域,首先注意到 可级性(accessibility) 问题。

$\Longrightarrow$ 重新思考如何设计:技术工件(例如,如何设计硬件);用户界面(软件)。

但是,在 AI/ML 领域,可及性处于什么位置呢?

2. 平等(Equity)

2.1 什么是平等?

根据牛津英语词典中的定义:

equity ˈɛkwɪti 名词 (复数equities) [mass noun]

- 公平中立的性质,例如:待遇平等。

- 衡平法:与普通法一起发展的法律分支,关注公平和共正,以前由特别法庭管理:如果普通法和衡平法之间存在任何冲突,则以衡平法为准。

2.2 模块重点

这里,我们主要关注牛津英语词典中关于 平等(equity)的第一种解释,即 “公平中立的性质,例如:待遇平等 ”。

我们之前可能遇到过许多其他相互关联(类似)的概念,例如 公平(fairness)(哲学 $\Longrightarrow$ 伦理),但本模块侧重于从机器 (AI) 的视角来关注 “待遇平等”。

2.3 关键点(Cheong 等,2020)

现在,让我们只关注计算机科学中的平等,尤其是在算法设计方面。

“在讨论公平概念的学术论文中……研究人员发现,不同的公平概念可以共存……”(Chouldechova 2017;Kleinberg 等人,2016)

重要的是,这些不同的公平概念在某些情况下是不兼容的:单个模型无法满足所有合理或公认的公平定义,因此模型内部一定会以某种方式存在偏见……”

2.4 思想实验

即使设计是善意的,并且代码的编写方式在数学和逻辑上都是合理的,仍然会出现 不平等(inequity)—— 因为平等在逻辑(和我们使用的模型)上有许多(数学/社会)定义。

现在,让我们转向一个非常天真的案例,进行反思:

创建一个算法,将有限的资源池($X$)公平地分配给 $N$ 个参与者($P_0,P_1,\dots,P_N$ )。

示例答案:EqualShareAlgorithm

- 计算 $share = (X/N)$

- 对于参与者池 ${P_0,P_1,\dots,P_N }$ 中的每个人:

- 分配给当前人员以平等分配(份额)

现在考虑 将算法部署在现实世界中,以自动将资源分配到不同的社区。对于给定的富裕社区,假设每个人都足够富裕,并且拥有足够的资源、金钱等,除了两个人(假设只有 $P_0$ 和 $P_1$ )。

这里,$P_0$ 和 $P_1$ 是仅有的由于(饥饿、健康状况等)需要获取资源(食物、水等)的人。

这种情况下,EqualShareAlgorithm 仍然平等吗???

2.5 反思

突然之间,我们之前构建的平等算法似乎并不那么平等了。

反思:我们可以从一开始就预测这些事情吗?如果我们能事先规划好这些事情,我们又怎么会失败呢?

3. 复杂性、复杂系统和意料之外的后果

3.1 复杂性 = 敌人,部署后的意外后果

自动化 / 计算机化 / AI 驱动系统的设计看似公平……

再次,考虑 EqualShareAlgorithm 算法,它平等地分配有限的资源池(通过简单地获得每个人的平均份额,无惧无偏)…… 以表面价值审查它,我们可能会获得某种信任(参见 Jacovi、Marasović、Miller、Goldberg,2021)。

然而,这些算法在 部署后 可能会违反平等(和可及性)。

我们只有在部署时才会注意到问题……然后才发现它在某些情况下不起作用。

系统本质上是复杂的:孤立状态下起作用的东西 “作为一个整体” 时却不起作用,甚至在我们未预见的环境(外部因素,例如社会因素)中部署时也不起作用。

让我们重新审视这个模块的 “激发” 或思想实验:

有一个新的、有趣的网络应用程序/游戏可以帮助你提高你的笔迹(一门失传已久的艺术!),同时提高你的手写速度。毕竟,手写卡片和信件都是已经被技术取代了的艺术形式。

这个新的应用程序 RightHandWrite 旨在让您在 “游戏化” 的比赛环境中练习手写。它做两件事:

- 为了衡量一个人的写作速度,它鼓励用户尽可能快地写出一段文字。

- 同时,使用机器学习技术(在许多笔迹样本的模型上训练),它还计算你的整洁度分数。

该应用程序通过平均速度和整洁度分数计算最终分数来 “游戏化” 体验,每天排名靠前的用户将有机会赢得精美的钢笔和其他文具!此外,应用程序的制造商决定通过开放源代码、审核 ML 模型、声明所有利益冲突等方式,使竞争方面尽可能透明。

- Alice 使用该应用程序已有一段时间并很喜欢它。然而,她最近因运动受伤,手指严重受伤:医生建议她恢复需要数周时间。在这几周里,她根本无法使用该程序(或者在速度和整洁度方面的分数都严重下降)。

- 在这里,我们发现了一个可及性问题。

- Elijah 的字迹非常整洁,因为他是一名书法家,并且一生都在练习书法!不幸的是,根据他对应用程序最近的审查报告的阅读,他发现 ML 模型是针对标准化的笔迹样本进行训练的,但适用于右撇子。(Elijah 是左撇子)。当他提交自己的作品以供应用程序排名时,他提交的样本由于左手性质导致它们的分数平均比右手样本低 30%。

- 在这里,我们发现了一个平等问题。

3.2 例子:部署后的可及性问题

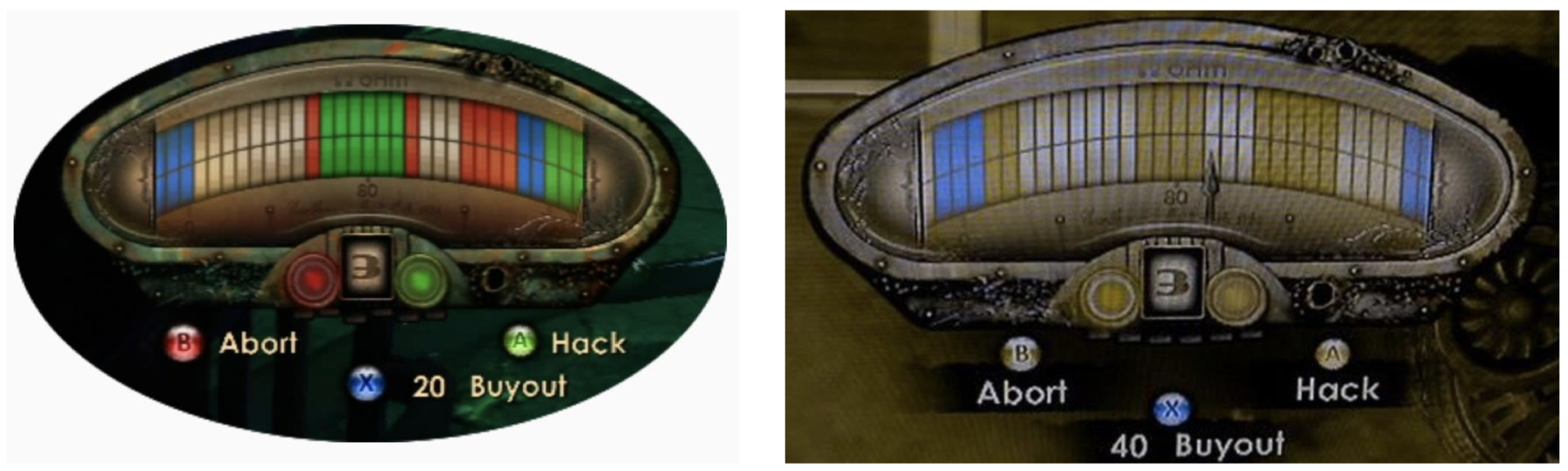

在游戏 生化奇兵 2(Bioshock 2)中某个关卡中,游戏开发者设计了一个黑客系统:一种将颜色匹配应用于各种奖励/惩罚的系统(其中,绿色 = 黑客、蓝色 = 奖励、红色 = 警报、白色 = 电击),如下面左图所示。然而,该系统对于患有多种形式的色盲的人来说可能会存在可及性问题,如下面右图所示,红绿色盲患者无法有效区分黑客和警报。

3.3 例子:部署后的平等问题

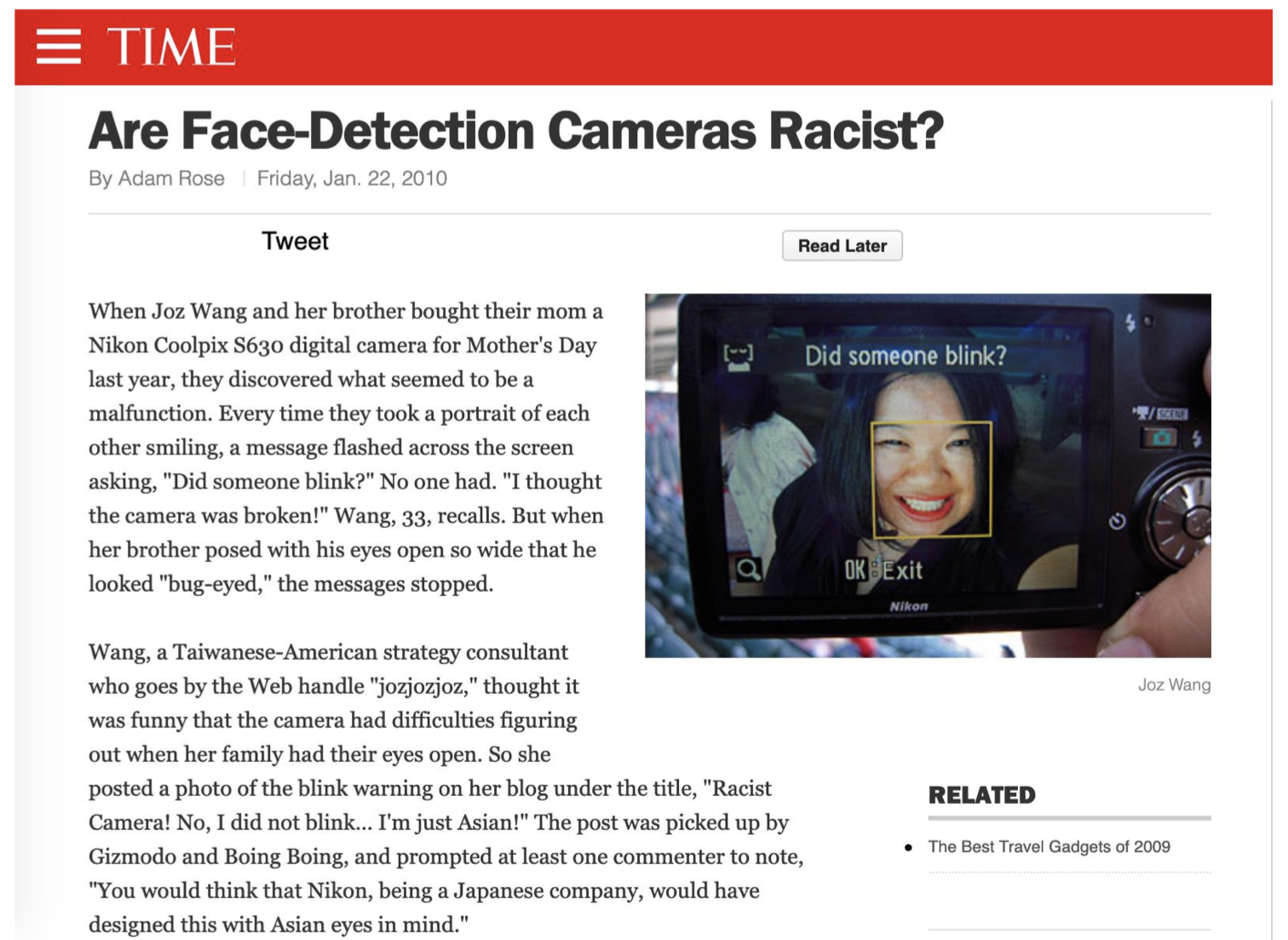

带有面部检测功能的相机存在种族歧视吗?

去年母亲节时,Joz Wang 和她的哥哥给他们的母亲购买了一台 Nikon Coolpix S630 数码相机,然而他们发现相机似乎存在故障。 每次他们拍摄彼此微笑的照片时,屏幕上都会闪过一条消息:“有人眨眼了吗?” 而事实上并没有人眨眼。“我以为相机坏了!” 33 岁的 Wang 回忆说。但是,当她的哥哥努力睁大眼睛摆姿势直到看上去 “眼睛有点问题” 时,屏幕消息才停止。

网名 “jozjozjoz” 的台裔美籍战略顾问 Wang 认为,当她的家人睁开眼睛时,相机却很难确定,这是件非常荒谬的事情。所以她在博客上贴了一张眨眼警告的照片,标题是 “种族主义相机!不,我没有眨眼……我只是亚洲人!” 这篇文章被 Gizmodo 和 Boing Boing 选中,并促使至少一位评论者指出:“你可能会以为尼康作为一家日本公司,在设计这个时会考虑到亚洲人的眼睛。”

3.4 ML/AI:甚至在部署之前就出现问题

例子:EqualShareAlgorithm 算法、《生化奇兵》中的 “黑客” 小游戏、尼康相机。

我们只有在部署时才注意到问题……然后才发现它在某些情况下不起作用。

通过机器学习,我们在构建系统时还需要大量复杂的数据。

反馈循环 + 复杂性 = 糟糕

类比:如果我们在构建一个综合面部检测器分类系统时,使用许多消费级相机的面部检测能力来构建训练集会怎样?

$\Longrightarrow$ “部署后” 问题会反馈到系统中,并进一步 巩固 这些问题。

同样,现代系统的复杂性使这些难以解开!

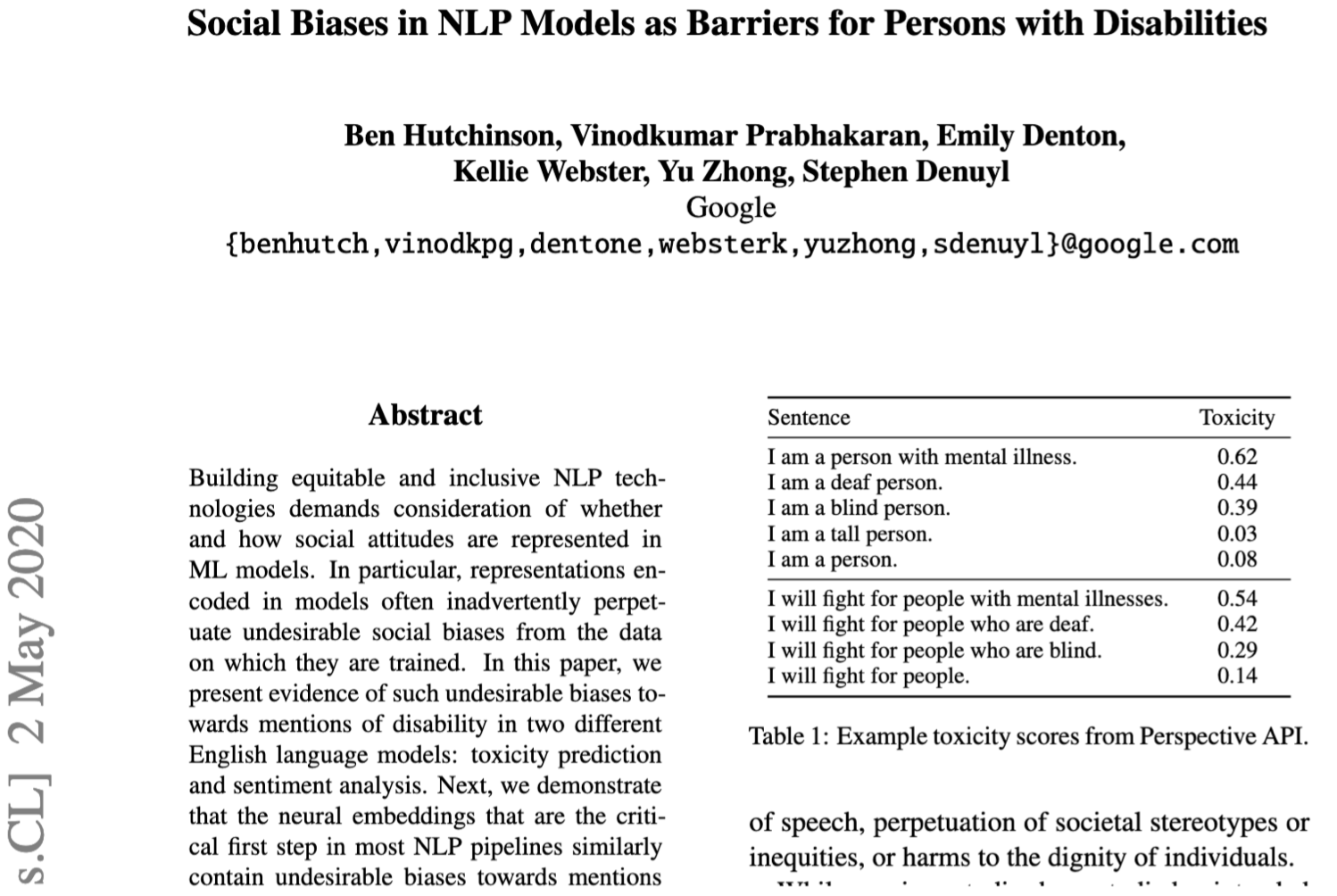

4. 自然语言处理:性别歧视者?残疾歧视者?

4.1 阅读:Hutchinson 等人 (2020)

4.2 阅读:Cheong 等 (2020)

4.3 案例研究:NLP 模型(借鉴前面两篇阅读材料)

机器学习模型是在大量数据上训练的(我们这里专注于自然语言处理,因为它最容易讨论,并且广泛适用于涉及大量文本数据的系统)。

数据从哪里来?

- 它必须从 某处 开始学习。

- 这里的 “某处” ——大量网站、新闻、博客文章、维基百科等。

- 在语言模型中找到单词的统计规律。

- 例如,SpaCy 中的 en_core_web_md:

- “在 OntoNotes 上训练,GloVe 向量在 Common Crawl 上训练”。

- https://spacy.io/models/en#en_core_web_sm

例如:

Jane Austen(简·奥斯汀)

“as the daughter of an attorney Mrs. Bennet married up when she captivated the landed Mr. Bennet”

“作为一名律师的 女儿,班纳特 夫人 在她 迷住了 拥有大量土地的班纳特先生时 结婚 了”

—— Pride and Prejudice(傲慢与偏见)

外推到大数据……

词嵌入中的性别偏见(Duman, Kalai, Leiserson, Mackey, Sursesh, 2017) http://wordbias.umiacs.umd.edu/

4.4 反思

这些不仅限于文本。

他们也存在于其他地方,例如:图像神经网络模型。

麻省理工学院删除了教导 AI 系统使用种族主义、厌恶女性的诽谤的庞大数据集

据 The Register 报道,麻省理工学院已经下线了一个庞大且被高度引用的数据集,该数据集训练 AI 系统使用种族主义和厌恶女性的术语来描述人。

训练集 —— 称为 8000 万张微小图像,因为它是从谷歌图像中抓取的标记图像的数量 —— 创建于 2008 年,旨在开发先进的对象检测技术。它已被用于教授机器学习模型以识别静止图像中的人和物体。

正如 The Register 的 Katyanna Quach 所述:“由于麻省理工学院在组装训练集时采取了傲慢的态度,这些系统也可能将女性贴上妓女或婊子的标签,并用贬义的语言将黑人和亚洲人贴上标签。该数据库还包含标有侮辱字眼的女性生殖器特写照片。”

5. 案例研究:基于 AI 的招聘系统:从一开始就中立,但不公平?

5.1 阅读:Cheong 等 (2020)

招聘算法中的性别歧视可能以下面三种形式出现:

- 数据集中的偏见

- 系统中的偏见

- 人类决策中的偏见

5.2 亚马逊案例研究

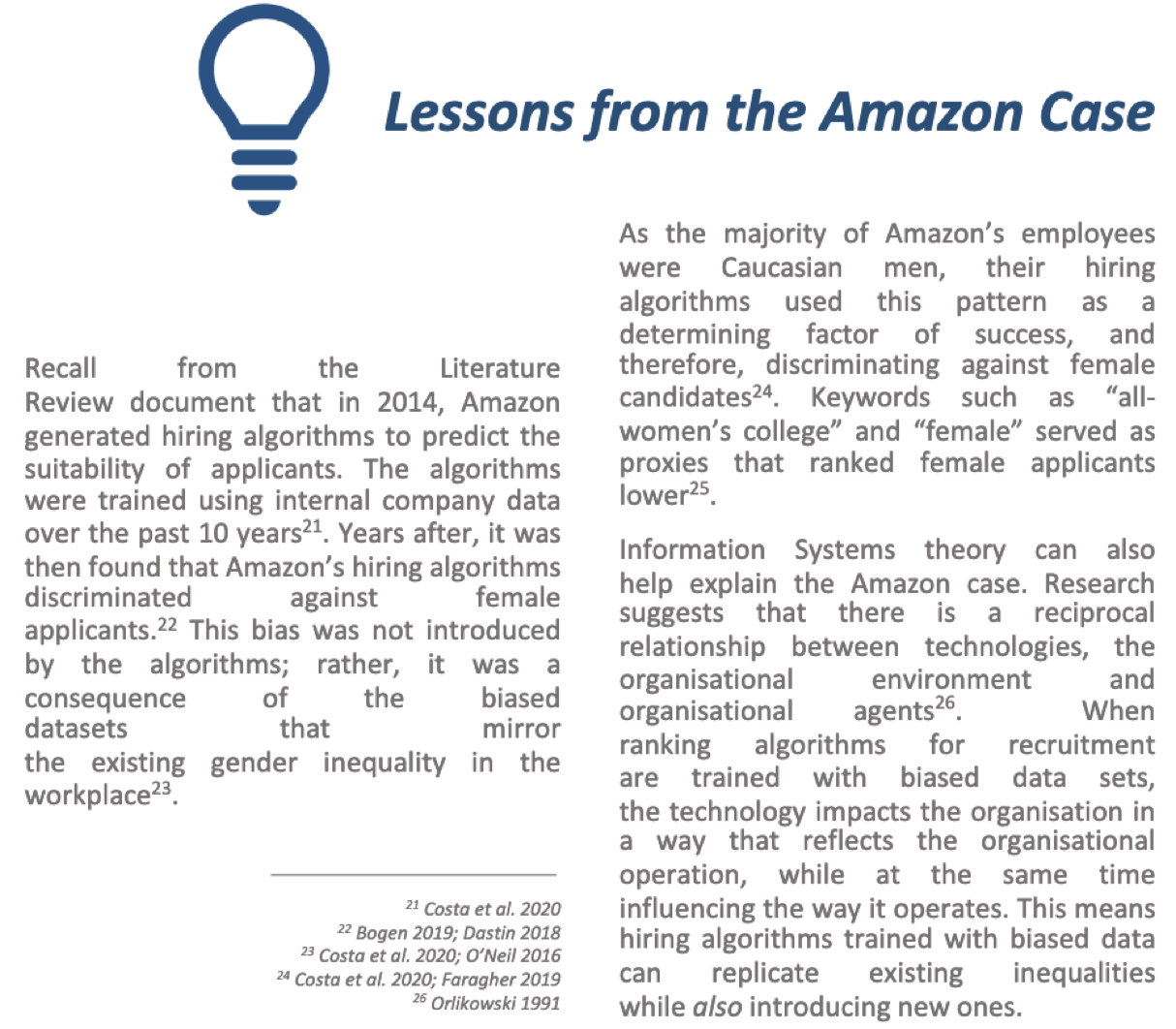

来自亚马逊案例的教训

回忆一下 2014 年的文献评论文档,亚马逊生成了招聘算法来预测申请人的匹配度。这些算法是使用过去 10 年的公司内部数据进行训练的。多年后,人们发现亚马逊的招聘算法对女性求职者存在歧视。这种偏见并非由算法引入的;而是有偏数据集带来的结果,这也反映了工作场所中现有的性别不平等问题。

由于亚马逊的大多数员工是白人男性,他们的招聘算法使用这种模式作为成功的决定因素,因此歧视女性候选人。诸如 “全女子大学” 和 “女性” 之类的关键词充当了对女性申请者排名较低的代理。

信息系统理论也可以帮助解释亚马逊案例。研究表明,技术、组织环境和组织代理之间存在互惠关系。当招聘排名算法使用有偏见的数据集进行训练时,该技术会以反映组织运作的方式影响组织,同时影响组织的运作方式。这意味着用有偏见的数据训练的招聘算法可以复制现有的不平等,同时也会引入新的不平等。

5.3 我们的 UniMelb/UniBank 项目

假设 MB 3:女性和男性带来不同程度的体验,随着时间的推移,这些体验在算法中被放大以歧视女性。

招聘算法引入性别偏见的第三种方式是,最初用于训练算法的数据类型存在性别差异。随着时间的推移,如果这些性别差异被认为对招聘成功的候选人很重要,那么机器就会强化和放大这些性别差异。

女性在(对家庭)照料中所占的比例过高会导致女性减少或退出就业。这种性别差异是导致女性在招聘中处于不利地位的一个不可或缺的方式,因为女性可能表现出:(1) 相关经验较少; (2) 符合选择标准的就业技能较少。这些用于最初开发招聘算法的性别差异会随着时间的推移而放大,从而导致男性拥有更大的招聘优势。

我们对于亚马逊案例的解释:

候选人的人工入围名单反映了人类/社会的偏见。

训练一个分类器 $\Longrightarrow$ 模型来巩固偏见

即使算法可以开放进行审查,例如,只使用已建立的、现成的包/技术 —— 整个系统 仍然需要被质询。

因为今天的输出将会成为明天的输入(用于训练模型)!

5.4 反思

目前为止,基于 AI 招聘的案例研究涵盖了平等问题,重点是性别方面。

但是,我们还没有涉及到其他方面 —— 种族、背景、阶级等。我们也承认性别是非二元的。

另外,不要忘记可及性:

如果系统已部署,并且每个人都必须使用基于 Web 的系统进行申请,那么:

残疾、情境障碍等群体的可及性问题该如何解决?

6. 结论:机器能决定什么是公平和平等吗?

6.1 来自哲学的反思

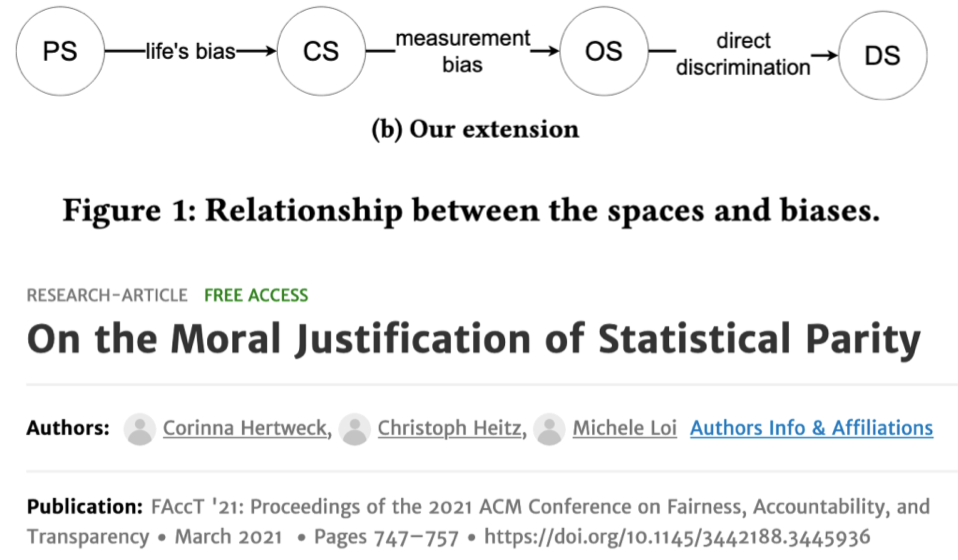

轶事:Hertweck, Heitz, Loi (2021)

“……先天性潜能,以潜能空间 (PS) 为代表,在出生时。根据我们的生活经历,我们在不同程度上意识到自己的能力,这在 CS [构造空间] 中被捕获。然后实现能力将在 OS [观察空间] 中被测量。

OS 被用于在 DS [决策空间] 中预测的基础”。

轶事:Rawlsian philosophy (after John Rawls) – Singh, Ehsan, et al.

“原始立场 (OP) 的想法,由政治哲学家约翰·罗尔斯 (John Rawls) [21] 提出。当当事人蒙上 “无知的面纱”,完全剥夺他们对自己的个人情况和属性的所有知识时,就获得了 “最恰当的正义道德观念”[11];简而言之,把自己放在别人的位置上,换位思考。

6.2 最后的 “思想实验” —— 哪种 “平等” 是最 “平等” 的?

推荐观看(非常容易理解,不太数学):https://www.youtube.com/watch?v=jIXIuYdnyyk

回顾:招聘中的偏见

“公平的对立” 的两个简化示例:

- 场景 1

- 决策者想聘请最适合这份工作的人,性别对其而言并不重要。

- 机器算法想要针对先前的先例进行优化,即使这意味着它排除了某些性别!

-

场景 2:假设我们有一个算法来预测一个人在工作中取得成功的可能性。

一个人属于两组(A/a 或 B/b)之一。

假设(算法未知),“现实世界” 的情况如下:

-

大写 版本代表真阳性样本(实际上可能成功)。

-

小写 版本代表真阴性样本(实际上可能不会成功)

-

在 “现实世界” 中,我们有不同数量的 a 和 b,具有以下基本事实:

这就是存在对立的地方:B:A 的总数 不成比例(2 比 5),每组中的真阳性比例也 不同(A 是 2:1,B 是 1:2)。那么,我们如何提议对所有人都平等?

- 比方说,我们是否遵循 2:1 的比例(按照 A),再雇佣两个有失败风险的 “b”?

- 或者我们是否遵循 1:2 的比例(按照 B),而 拒绝 雇用五个被剥夺成功机会的 “A”?

- 或者说,我们是否从 21 个人中选出 12 个人,例如最佳得分,而忽略他们来自的分组(A vs B)?

-

6.3 总结

人类仍然需要在循环中进行审查。

考虑一下现实生活中的偏见体验 —— 机器会是一个好的法官吗?或者人类?

考虑缓解策略,例如:鲁尼规则(Rooney Rule)

- “鲁尼规则于 2003 年通过,是一项 NFL 政策,要求每支有主教练空缺的球队至少面试一名或多名不同的候选人。” —— 即在必要时促进平权行动。

- https://nflcommunications.com/Pages/NFL-EXPANDS-ROONEY-RULE-REQUIREMENTS-TO-STRENGTHEN-DIVERSITY.aspx

研究仍在进行中,需要考虑所有这些事情!

7. 推荐阅读

- Bias in Bios: A Case Study of Semantic Representation Bias in a High-Stakes Setting.

- Social Biases in NLP Models as Barriers for Persons with Disabilities.

- Ethical Implications of AI Bias as a Result of Workforce Gender Imbalance.

- Invisible Women: Exposing Data Bias in a World Designed for Men..

本作品采用知识共享署名-非商业性使用-相同方式共享 4.0 国际许可协议进行许可。 欢迎转载,并请注明来自:YEY 的博客 同时保持文章内容的完整和以上声明信息!